說明

LayerNorm中不會像BatchNorm那樣跟蹤統計全局的均值方差,因此train()和eval()對LayerNorm沒有影響���。

LayerNorm參數

torch.nn.LayerNorm(

normalized_shape: Union[int, List[int], torch.Size],

eps: float = 1e-05,

elementwise_affine: bool = True)

normalized_shape

如果傳入整數�����,比如4,則被看做只有一個整數的list��,此時LayerNorm會對輸入的最后一維進行歸一化��,這個int值需要和輸入的最后一維一樣大。

假設此時輸入的數據維度是[3, 4]��,則對3個長度為4的向量求均值方差,得到3個均值和3個方差�����,分別對這3行進行歸一化(每一行的4個數字都是均值為0,方差為1)�;LayerNorm中的weight和bias也分別包含4個數字�����,重復使用3次����,對每一行進行仿射變換(仿射變換即乘以weight中對應的數字后�,然后加bias中對應的數字)�����,并會在反向傳播時得到學習����。

如果輸入的是個list或者torch.Size,比如[3, 4]或torch.Size([3, 4])�����,則會對網絡最后的兩維進行歸一化����,且要求輸入數據的最后兩維尺寸也是[3, 4]��。

假設此時輸入的數據維度也是[3, 4]�,首先對這12個數字求均值和方差,然后歸一化這個12個數字���;weight和bias也分別包含12個數字����,分別對12個歸一化后的數字進行仿射變換(仿射變換即乘以weight中對應的數字后,然后加bias中對應的數字),并會在反向傳播時得到學習��。

假設此時輸入的數據維度是[N, 3, 4],則對著N個[3,4]做和上述一樣的操作,只是此時做仿射變換時�,weight和bias被重復用了N次����。

假設此時輸入的數據維度是[N, T, 3, 4]�,也是一樣的��,維度可以更多�。

注意:顯然LayerNorm中weight和bias的shape就是傳入的normalized_shape。

eps

歸一化時加在分母上防止除零�。

elementwise_affine

如果設為False�,則LayerNorm層不含有任何可學習參數。

如果設為True(默認是True)則會包含可學習參數weight和bias�����,用于仿射變換�,即對輸入數據歸一化到均值0方差1后�����,乘以weight�����,即bias�。

LayerNorm前向傳播(以normalized_shape為一個int舉例)

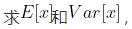

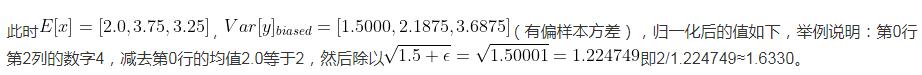

1、如下所示輸入數據的shape是(3, 4)�,此時normalized_shape傳入4(輸入維度最后一維的size)����,則沿著最后一維(沿著最后一維的意思就是對最后一維的數據進行操作) 并用這兩個結果把batch沿著最后一維歸一化,使其均值為0,方差為1����。歸一化公式用到了eps()��,即

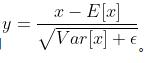

并用這兩個結果把batch沿著最后一維歸一化,使其均值為0,方差為1����。歸一化公式用到了eps()��,即

tensor = torch.FloatTensor([[1, 2, 4, 1],

[6, 3, 2, 4],

[2, 4, 6, 1]])

[[-0.8165, 0.0000, 1.6330, -0.8165],

[ 1.5213, -0.5071, -1.1832, 0.1690],

[-0.6509, 0.3906, 1.4321, -1.1717]]

2、如果elementwise_affine==True�,則對歸一化后的batch進行仿射變換�,即乘以模塊內部的weight(初值是[1., 1., 1., 1.])然后加上模塊內部的bias(初值是[0., 0., 0., 0.]),這兩個變量會在反向傳播時得到更新�。

3����、如果elementwise_affine==False,則LayerNorm中不含有weight和bias兩個變量,只做歸一化,不會進行仿射變換。

總結

在使用LayerNorm時,通常只需要指定normalized_shape就可以了����。

補充:【Pytorch】F.layer_norm和nn.LayerNorm到底有什么區別����?

背景

最近在做視頻方向�����,處理的是時序特征����,就想著能不能用Batch Normalization來做視頻特征BN層�?在網上查閱資料發現,時序特征并不能用Batch Normalization,因為一個batch中的序列有長有短�����。

此外����,BN 的一個缺點是需要較大的 batchsize 才能合理估訓練數據的均值和方差�����,這導致內存很可能不夠用�����,同時它也很難應用在訓練數據長度不同的 RNN 模型上。

Layer Normalization (LN) 的一個優勢是不需要批訓練�,在單條數據內部就能歸一化��。

對于RNN等時序模型,有時候同一個batch內部的訓練實例長度不一(不同長度的句子)����,則不同的時態下需要保存不同的統計量,無法正確使用BN層����,只能使用Layer Normalization��。

查閱Layer Normalization(下述LN)后發現����,這東西有兩種用法���,一個是F.layer_norm����,一個是torch.nn.LayerNorm���,本文探究他們的區別。

F.layer_norm

用法

F.layer_norm(x, normalized_shape, self.weight.expand(normalized_shape), self.bias.expand(normalized_shape))

其中:

x是輸入的Tensor

normalized_shape是要歸一化的維度����,可以是x的后若干維度

self.weight.expand(normalized_shape),可選參數�,自定義的weight

self.bias.expand(normalized_shape)�,可選參數�,自定義的bias

示例

很容易看出來,跟F.normalize基本一樣��,沒有可學習的參數��,或者自定義參數�����。具體使用示例如下:

import torch.nn.functional as F

input = torch.tensor(a)

y = F.layer_norm(input,(4,))

print(y)

#####################輸出################

tensor([[[-0.8095, -1.1224, 1.2966, 0.6354],

[-1.0215, -0.9661, 0.8387, 1.1488],

[-0.3047, 1.0412, -1.4978, 0.7613]],

[[ 0.4605, 1.2144, -1.5122, -0.1627],

[ 1.5676, 0.1340, -1.0471, -0.6545],

[ 1.5388, -0.3520, -1.2273, 0.0405]]])

添加縮放:

w = torch.tensor([1,1,2,2])

b = torch.tensor([1,1,1,1])

y = F.layer_norm(input,(4,),w,b)

print(y)

#########################輸出######################

tensor([[[ 0.1905, -0.1224, 3.5931, 2.2708],

[-0.0215, 0.0339, 2.6775, 3.2976],

[ 0.6953, 2.0412, -1.9956, 2.5225]],

[[ 1.4605, 2.2144, -2.0243, 0.6746],

[ 2.5676, 1.1340, -1.0942, -0.3090],

[ 2.5388, 0.6480, -1.4546, 1.0810]]])

nn.LayerNorm

用法

torch.nn.LayerNorm(

normalized_shape: Union[int, List[int], torch.Size],

eps: float = 1e-05,

elementwise_affine: bool = True)

normalized_shape: 輸入尺寸, [∗×normalized_shape[0]×normalized_shape[1]×…×normalized_shape[−1]]

eps: 為保證數值穩定性(分母不能趨近或取0),給分母加上的值�。默認為1e-5。

elementwise_affine: 布爾值,當設為true,給該層添加可學習的仿射變換參數�����。

示例

elementwise_affine如果設為False����,則LayerNorm層不含有任何可學習參數。

如果設為True(默認是True)則會包含可學習參數weight和bias����,用于仿射變換�,即對輸入數據歸一化到均值0方差1后��,乘以weight,即bias�。

import torch

input = torch.randn(2,3,2,2)

import torch.nn as nn

#取消仿射變換要寫成

#m = nn.LayerNorm(input.size()[1:], elementwise_affine=False)

m1 = nn.LayerNorm(input.size()[1:])#input.size()[1:]為torch.Size([3, 2, 2])

output1 = m1(input)

#只normalize后兩個維度

m2 = nn.LayerNorm([2,2])

output2 = m2(input)

#只normalize最后一個維度

m3 = nn.LayerNorm(2)

output3 = m3(input)

總結

F.layer_norm中沒有可學習參數����,而nn.LayerNorm有可學習參數���。當elementwise_affine設為False時�,nn.LayerNorm退化為F.layer_norm���。

以上為個人經驗��,希望能給大家一個參考,也希望大家多多支持腳本之家。

您可能感興趣的文章:- pytorch固定BN層參數的操作

- pytorch 如何自定義卷積核權值參數

- pytorch交叉熵損失函數的weight參數的使用

- Pytorch 統計模型參數量的操作 param.numel()

- pytorch 一行代碼查看網絡參數總量的實現

- pytorch查看網絡參數顯存占用量等操作

- pytorch 優化器(optim)不同參數組,不同學習率設置的操作