目錄

- 一、網址分析

- 二、代碼編寫

- 三、遇到的問題

- 1. 獲取評論的時候也將子評論爬蟲進去了。

- 2. 獲取全部評論數,直接通過 requests 獲取不到

- 3. 評論總數數據太大

- 4. 報錯'utf-8' codec can't decode byte 0xff in position 1: invalid start byte

- 四、完整代碼

一、網址分析

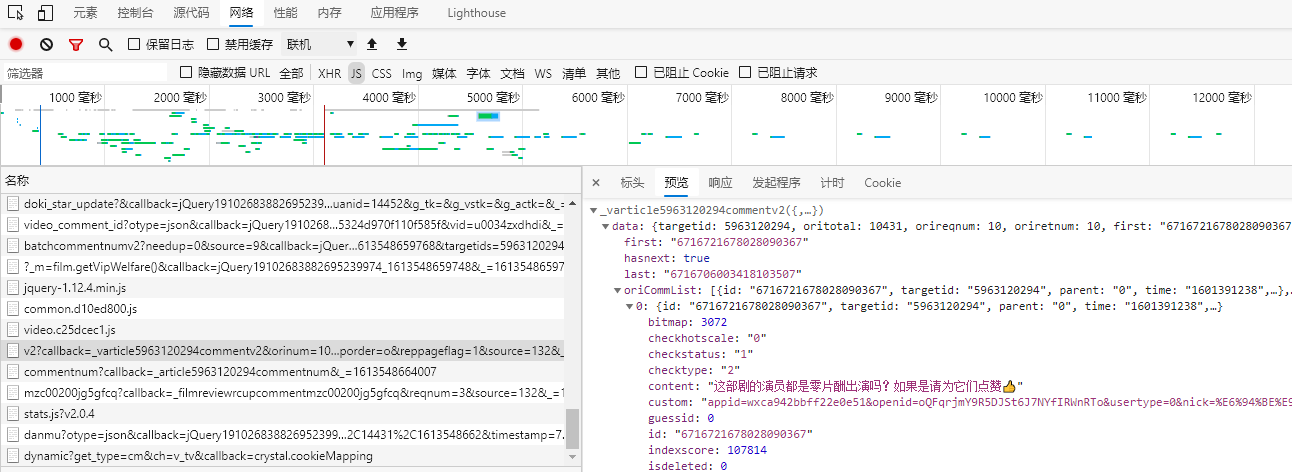

查閱了網上的大部分資料,大概都是通過抓包獲取。但是抓包有點麻煩,嘗試了F12,也可以獲取到評論。以電視劇《在一起》為例子。評論最底端有個查看更多評論猜測過去應該是 Ajax 的異步加載。

網上的大部分都是構建評論的網址,通過 requests 獲取,正則表達式進行數據處理。本文也利用該方法進行數據處理,其實利用 scrapy 會更簡單。

根據前輩給出的經驗,順利找到了評論所在的鏈接。

在新標簽中打開,該網址的鏈接。

評論都在"content":"xxxxx"里面,所有可以通過正則表達式獲取。

那么現在要開始構建網址,找到其規(guī)律。

在查找評論鏈接的過程中無意發(fā)現,點擊影評旁邊的評論總數,可以獲取到更為干凈的評論界面。結果是一樣的。

既然是要爬取所有的評論,所以知道評論數是必不可少的。

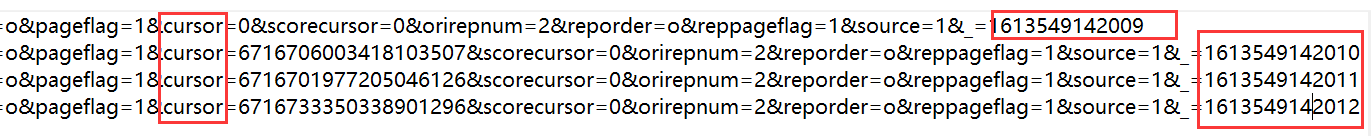

再通過F12獲取到評論鏈接,找到網址的規(guī)律,構建網址,加載三四個評論就行了。這里加載了四個網址。把所有網址復制到文本文件中,進行對比分析。

觀察發(fā)現只有 cursor 和 source 進行了改變,其他是不變的,二 source 是在第一個的基礎上進行加一操作,所以只需要獲取到 cursor 即可。我們打開一個評論鏈接的網址,我們可以知道,cursor 其實是上一頁 最后一個用戶的ID碼。所以我們只需要在爬取上一頁的時候一起爬蟲了。然后就可以構建網址。

二、代碼編寫

這個代碼還是簡單的。套用之前上課做的模板就可以直接進行爬蟲了。

通過正則表達式獲取評論,返回一個列表;

正則表達式獲得的 cursor 碼是列表,所以要轉化為字符串使用;

source 很簡單了,直接在上一個的基礎上加一即可。

def getComment(html): # 爬取單頁評論

findeComment = re.compile(r'"content":"(.*?)"', re.S)

comment = re.findall(findeComment, html)

# print(comment)

return comment

def getCursor(html): # 獲取下一頁的cursor碼

findeCursor = re.compile(r'"last":"(.*?)"', re.S)

cursor = re.findall(findeCursor, html)[0]

# print(cursor)

return cursor

def getSource(source): # 獲取下一頁的source碼

source = int(source) + 1

return str(source)

有點難度的可能就送弄代理吧,但是代理可以模仿網上其他人的寫法,所以還是不是很難。

#添加用戶代理

def ua(uapools):

thisua = random.choice(uapools)

# print(thisua)

headers = ("User-Agent", thisua)

opener = urllib.request.build_opener()

opener.addheaders = [headers]

# 設置為全局變量

urllib.request.install_opener(opener)

三、遇到的問題

1. 獲取評論的時候也將子評論爬蟲進去了。

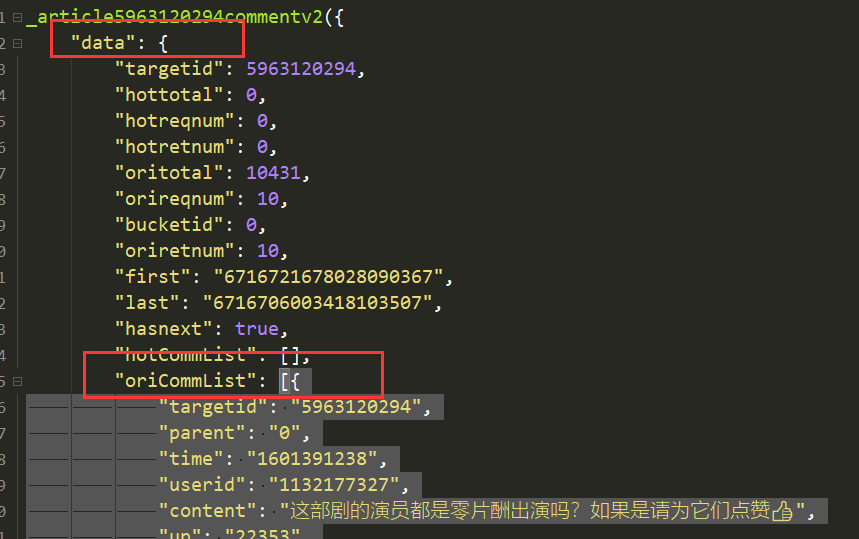

仔細查看了源碼,發(fā)現評論主要在 data 下面的 oriCommList 列表里,其他范圍的評論為子評論。個人認為子評論也算有效評論,目前不打算處理。

2. 獲取全部評論數,直接通過 requests 獲取不到

嘗試了 xpath 和 requests 發(fā)現不能獲取全部評論數,所以目前只能通過 selenium 獲取,但是 selenium 效率太低了,就獲取一個評論總數,還不如打開源碼直接修改評論總數,所以暫時沒有修改

3. 評論總數數據太大

因為之前爬蟲過很多網站,同一個 user-agent 很容易被 ban ,所以目前構建了用戶代理,然后進行隨機。其實還想加一個 ip 代理的,但是使用了 ip 代理的網址,上面寫的正常的 ip ,在使用的時候,拒絕連接。也嘗試過構建代理池。但是代理池一般都是使用docker 和 Redis 進行獲取。暫時沒有選用,之選用了用戶代理,然后在獲取 headers 的時候加個 time.sleep(1)。目前還是正常的。

4. 報錯'utf-8' codec can't decode byte 0xff in position 1: invalid start byte

遇到這個問題,實在無語,我懷疑后面的評論是新出的 emjoy,然后utf-8不能識別,程序掛掉了。但是選取其他格式,在解釋的過程估計還會掛掉,就暫時爬到1萬條吧。

四、完整代碼

代碼倉庫

以上就是python 爬取騰訊視頻評論的實現步驟的詳細內容,更多關于python 爬取騰訊視頻評論的資料請關注腳本之家其它相關文章!

您可能感興趣的文章:- Python爬取騰訊視頻評論的思路詳解

- 使用python實現抓取騰訊視頻所有電影的爬蟲

- 基于python實現的抓取騰訊視頻所有電影的爬蟲

- Python爬蟲小練習之爬取并分析騰訊視頻m3u8格式